当前位置:正文

港大败航等1bit大模子引热议,IEEE刊物评“处置AI动力需求”!作家亲身解读在此

极限量化,把每个参数占用空间压缩到1.1bit!

IEEE Spectrum专栏,一种名为BiLLM的训诲后量化(PTQ)模范火了。

平淡来讲,跟着LLM参数范畴越来越大,模子计较的内存和资源也濒临着更大的挑战。怎么把模子变得工整经济实惠,能塞进手机等成立中?

BiLLM处置的恰是这么的一个问题。它使用1bit来类似网罗中的大多数参数,使用2bit来清晰一些对性能最有影响的权重。

执行测试中,连络东谈主员对OPT模子、Llama系列进行了二值化。

在OPT模子家眷上,BiLLM以1.1bit的平均权流毒小结束了当今最极限的LLM训诲后压缩;在Llama系列模子上,BiLLM在1.08bit下的推崇致使卓越了使用全精度的OPT-66B模子。

服从方面,BiLLM简略在单个GPU上半小时内完成7B LLM的二值化。

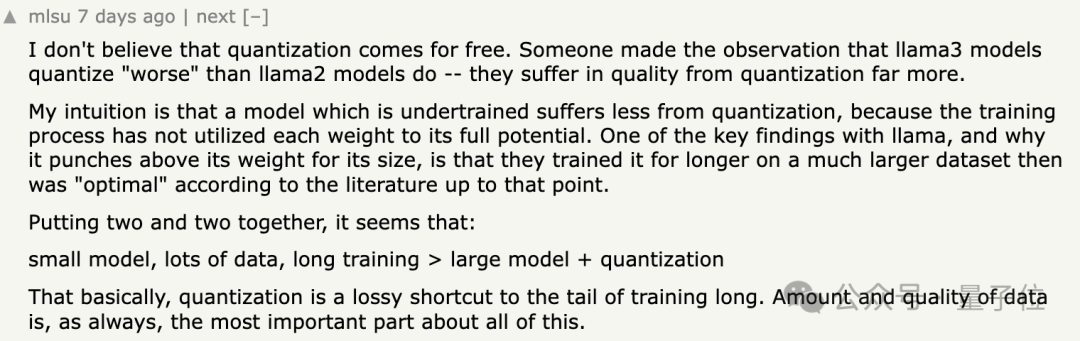

BiLLM发布今日,便激发了网友对大模子优化的热议,有网友就清晰:

量化不是莫得代价。Llama3模子的量化成果比Llama2模子要差,量化经由中的质料耗费更大。

直观是,一个训诲不及的模子受到量化的影响较小,因为其训诲经由并莫得充分诓骗每一个权重。对于Llama的一个要道发现,以及它为何能在其大小范围内推崇出色,是因为它们在比文件中所谓的“最好”现象更大的数据集上训诲了更永劫辰。

空洞这些成分,似乎不错得出以下论断:微型模子、多数数据、永劫辰训诲>大型模子+量化。基本上,量化是一种用于缩吊唁时辰训诲的耗费性的捷径。数据的数目和质料,一如既往是扫数这些中最遑急。

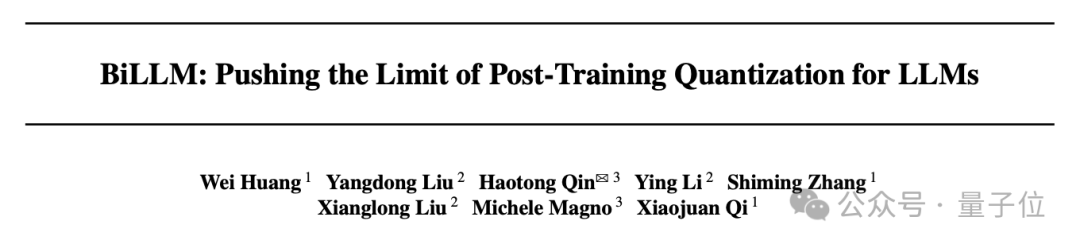

这项连络由香港大学、苏黎世联邦理工学院、北京航空航天大学鸠合推出,当今已被ICML 2024收受。

量子位也联系到了作家,给大伙儿解读一下。

LLM权重散播探究

为了应付超低位宽下大言语模子的才气崩溃问题,连络东谈主员对多个预训诲大言语模子的权重和其Hessian矩阵(耗费的二路子度)散播情况进行了初步连络,获取以下不雅察:

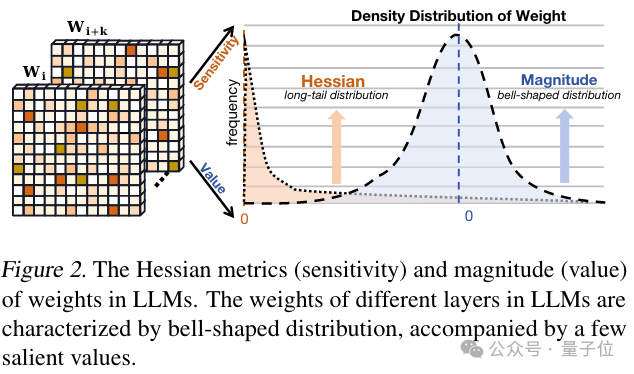

领先,连络东谈主员发现大言语模子的Hessian矩阵推崇出顶点的长尾散播特点。

这也意味着大多数位置权重的变化对模子的输入输出并不敏锐,而少部分元素对于权重的输出相配敏锐。

其次,大言语模子中的权重密度驯顺不均匀的钟形散播神志。

这种钟形散播在特征方面与高斯散播或拉普拉斯散播相配不异,即大多数权重集结在0近邻,举座呈现非均匀的钟形散播。

上述不雅察标明大多数权重在LLM当中是冗余的,而少部均权重施展着极其遑急的作用;同期,投资理财在顶点的二值化压缩场景下,这种非均匀钟形散播会产生更大的量化舛讹。

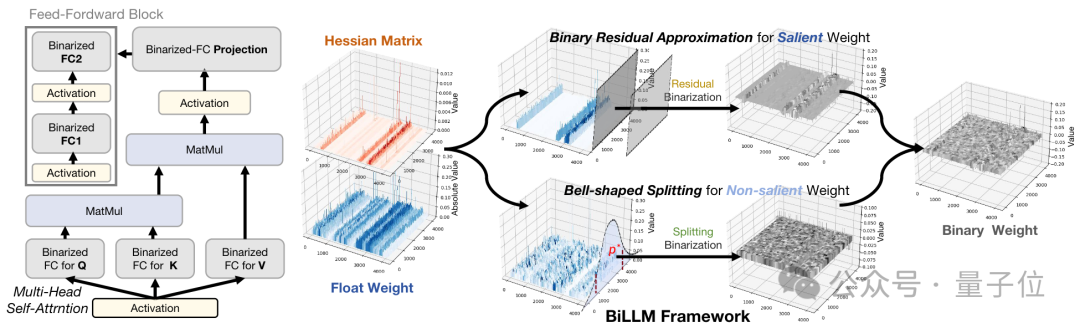

对此,连络东谈主员对少部分显赫权重和大部分非显赫权重分别提议了二阶残差靠拢和最优钟形分组模范进行量化,在1.1bit的权重下初次结束了LLM的性能保证。

△

LLM权重散播气象显赫权重:二阶残差靠拢

连络东谈主员发现,显赫权重时时积累在特定的通谈当中。

因此, BiLLM给与一种通谈级别的分组形式来区分显赫权重和非显赫权重。这种结构化分歧比拟于非结构化处理引入的支出不错忽略不计,对硬件部署十分友好。

△

显赫通谈权重二阶残差靠拢清晰图

由于显赫权重的遑急性,先前责任时时径直将这部均权重保存为原精度或量化到8-bit来保证LLM的性能。联系词,这种形式会导致举座位宽的加多。

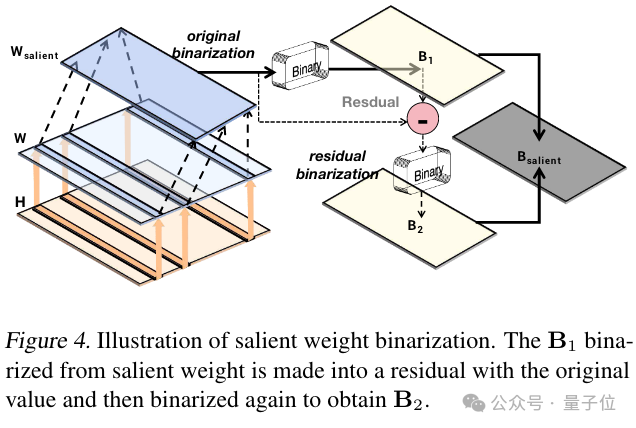

为此,连络东谈主员开垦了一种用二值化残差靠拢模范作用于显赫通谈的权重。

这一模范通过径直二值化和残差二值化有用镌汰了显赫权重的顶点量化舛讹。与径直保留光显权值为16位或者8位比拟,该模范仅通过2位支出存储光显权值,同期有用保护了权重中的遑急元素。

非显赫权重:最优钟形分歧

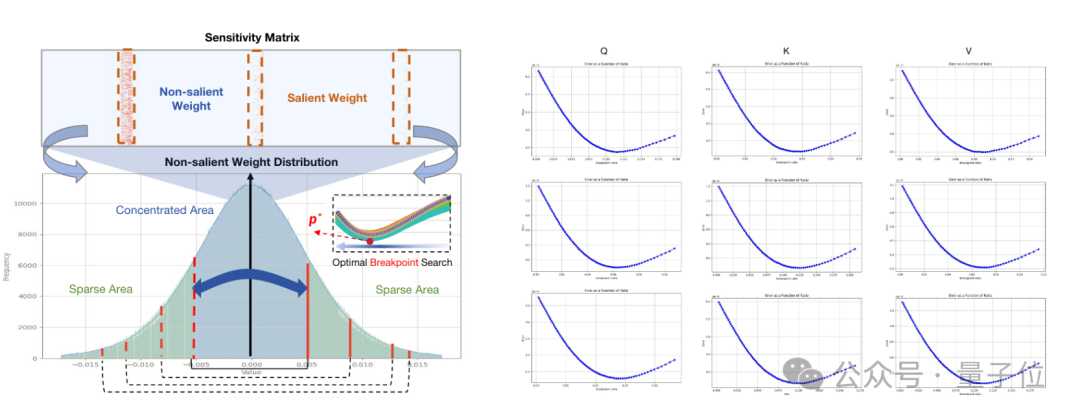

由于光显通谈数目极低,剩余的大部均权重仍然保合手着钟形散播。

同期,在摈斥光显权重影响的情况下变得愈加对称。由于二进制量化代表均匀量化的顶点神志,径直将钟形散播下的权重舍入到二值权重会带来雄伟的的量化舛讹。

因此连络东谈主员对这部均权重给与了分组二值化的形式,通过自动搜索政策寻找最优的分割点。

此外,连络截止标明,尽管非光显权重并非理念念的高斯散播或拉普拉斯散播,但搜索函数的舛讹弧线仍然推崇出凸性,阐述了最好分割点的存在。

△

非显赫权重散播搜索(左),搜索舛讹弧线的凸性(右)

同期由于外侧分组的数值方差较大,搜索中总所以较小的比例出现(0.5%~3%)。不错进一步给与疏淡行压缩的政策来进行分组标识,进一步培植细粒度分组决策下的硬件友好性。

执行截止

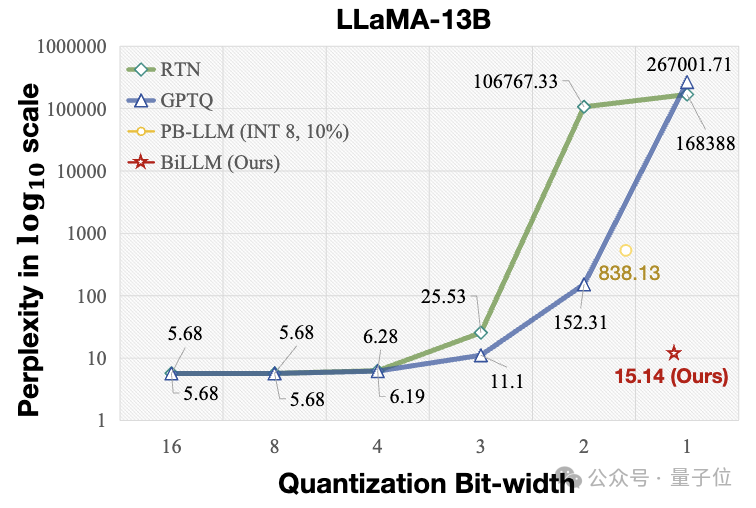

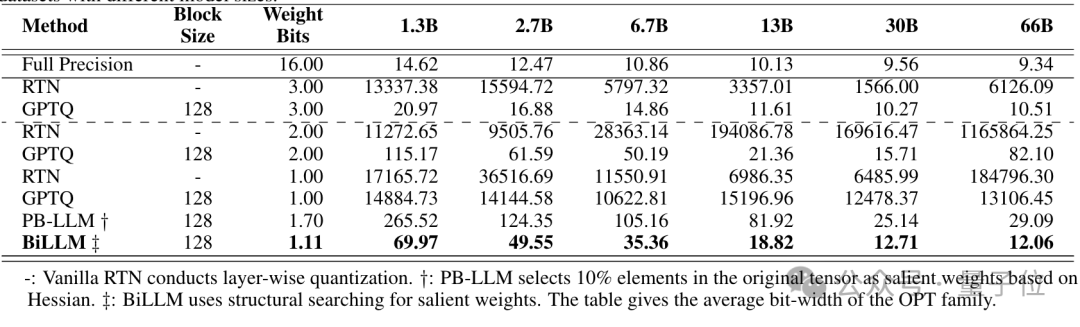

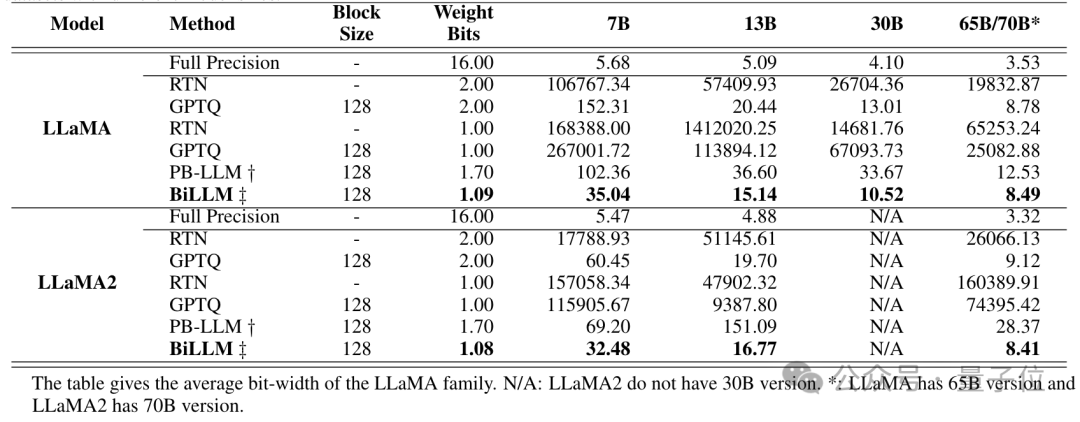

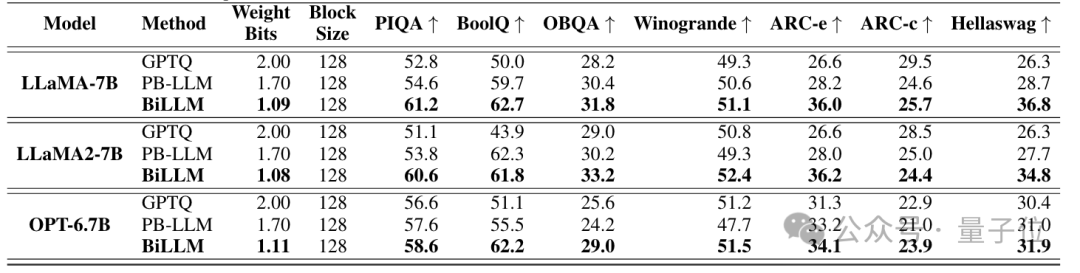

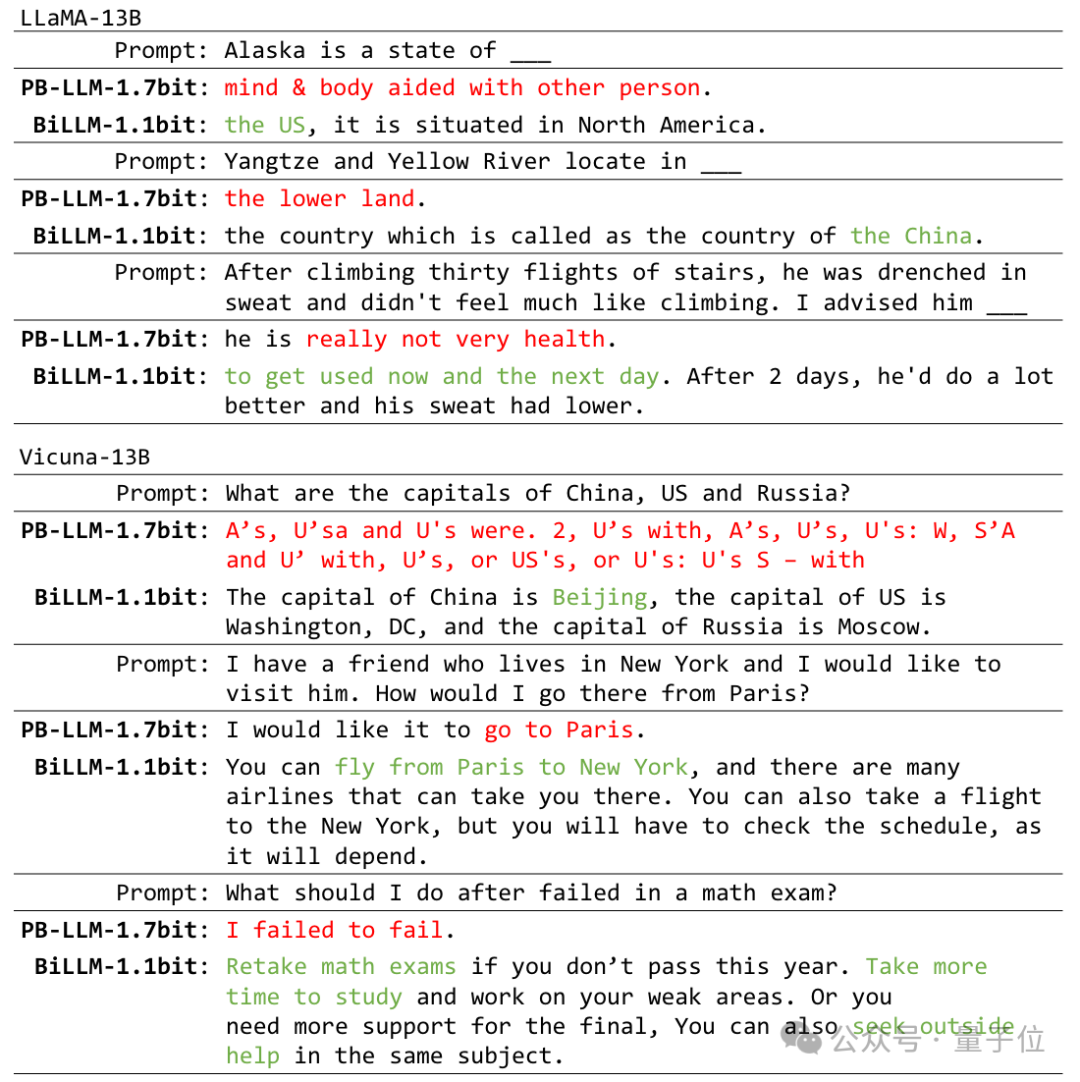

连络团队在OPT和Llama系列模子上考据了BiLLM性能。此外,接洽到LLM时时需要基于教唆进行微调以适合不同的应用环境,执行还申报了Vicuna-7B和Vicuna-13B的量化截止。

BiLLM在平均1.1bit权重时,在多个评价地方上结束了卓越GPTQ,PB-LLM等模范在2-bit时的性能,同期在部分模子体积上接近3-bit权重的性能。

截止标明, BiLLM 率先在接近1位的平均比特率下结束了LLM性能保证,推进了LLM无训诲量化的范围。

△

opt系列困惑度对比截止

△

Llama系列困惑度对比截止

△

Zero-Shot评测数据集对比截止

BiLLM在Llama-13B和Vicuna-7B上结束了更好对话成果。

— 完 —